Cerebras Systems, tillverkare av världens största processor, har slagit rekordet för den mest komplexa AI-modellen tränad med en enda enhet.

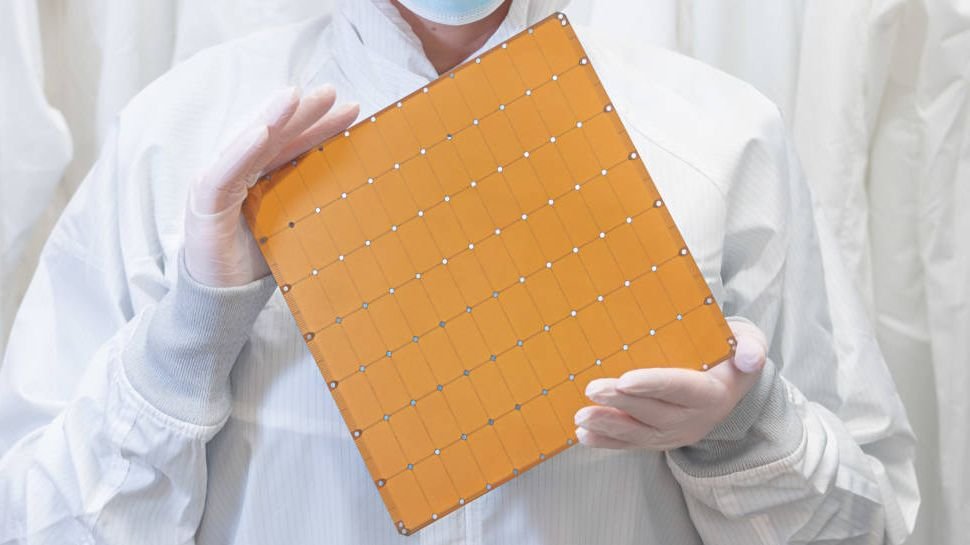

Med hjälp av ett CS-2-system, som drivs av företagets wafer-sized chip (WSE-2), kan Cerebras nu träna AI-modeller med upp till 20 miljarder parametrar genom nya optimeringar på mjukvarunivå.

Företaget säger att detta framsteg kommer att lösa ett av de mest frustrerande problemen för AI-ingenjörer: behovet av att dela upp storskaliga modeller över tusentals GPU:er. Resultatet är en möjlighet att dramatiskt minska tiden som behövs för att utveckla och träna nya modeller.

Cerebras ger AI till massorna

Inom subdiscipliner som naturlig språkbehandling (NLP) är modellprestanda linjärt korrelerad med antalet parametrar. Med andra ord, ju större modell, desto bättre slutresultat.

Idag innebär utveckling av storskaliga AI-produkter traditionellt att strömma en modell över ett stort antal GPU:er eller acceleratorer, antingen för att det finns för många parametrar att lagra i minnet eller för att det inte finns tillräckligt med datorprestanda för att hantera.

"Denna process är smärtsam och tar ofta månader," förklarade Cerebras. För att göra saken värre är processen unik för varje par av beräkningskluster i nätverket, så arbetet är inte överförbart mellan olika beräkningskluster eller neurala nätverk. Det är helt anpassat. »

Även om de mest komplexa modellerna består av mer än 20 miljarder parametrar, eliminerar förmågan att träna relativt storskaliga AI-modeller på en enda CS-2-enhet dessa flaskhalsar för många, vilket påskyndar utvecklingen för befintliga spelare och demokratiserar tillgången för dem som inte kunde göra det. så innan. . delta i rymden.

"Cerebras förmåga att leverera stora språkmodeller till allmänheten med enkel och kostnadseffektiv åtkomst markerar början på en spännande ny era inom AI. Det ger organisationer som inte kan spendera tiotals miljoner en enkel, prisvärd väg till NLP i stora ligan”, säger Dan Olds, forskningschef på Intersect360 Research.

"Det kommer att bli intressant att se de nya applikationerna och upptäckterna som CS-2-klienter kommer att göra genom att träna GPT-3- och GPT-J-klassmodellerna på massiva datamängder."

Dessutom antydde Cerebras att dess CS-2-system skulle kunna hantera ännu större modeller i framtiden, med "även biljoner parametrar." Samtidigt kan daisy chaining flera CS-2-system bana väg för AI-nätverk som är större än den mänskliga hjärnan.